Im Artikel „Bookmark richtig setzen“ habe ich kurz Bookmarks sowie die Nutzung von Bookmark-Submittern beschrieben. Heute möchten wir die Auswirkungen auf das Suchmaschinen Ranking einer Webseite durch das Setzen von Bookmarks prüfen.

Test 1: Setzen von Bookmarks auf die Hauptseite

Zuerst habe ich getestet, wie sich Bookmarks auf eine Hauptseite verhalten. Vorauszuschicken muss man, dass dies genau von vielen SEOs als falsch empfunden wird. Ich persönlich bin auch der Meinung, dass man dies unterlassen sollte, wollte jedoch die Auswirkung testen. Die Seite selbst ist für mich keine Hauptseite und schon einige Jahre alt. Sie dümpelt in den Suchergebnissen vor sich hin, so dass die zu erwartenden Erfahrungen sehr spannend waren. Im ersten Test habe ich also über 70 Bookmarks automatisiert auf die Startseite „geschossen“. Wie wir in der Statistik sehen können, hat die große Suchmaschine sehr positiv auf die Bookmarks reagiert. Die Impressionen haben sich mehr als verdoppelt.

Test 2: Setzen von Bookmarks auf bestehende AVZ-Einträge

Gängige Meinung der SEOs ist, dass man Bookmarks nicht für eine Hauptseite, sondern zur Unterstützung von Backlinks nutzen sollte. Also habe ich versucht, ältere AVZ-Einträge mit Bookmarks zu beglücken. An den darauffolgenden vier Tagen (nach Test 1) habe ich an je einem Tag eine AVZ-URL mit Link zu meiner Hauptseite mit Bookmarks versorgt. In der Grafik ist zu erkennen, dass sich dies positiv auf die Impressionen ausgewirkt hat. Aber eine „wahre Explosion“ ist nicht erfolgt.

Nachhaltigkeit von Test 1 und Test 2

Leider habe ich beide Tests direkt nacheinander durchgeführt, so dass die beiden Tests nur zusammen betrachtet werden können. Zu beobachten war, dass die Impressions massiv zugenommen haben. Leider war die Zunahme nur ein Strohfeuer. Nach rund 14 Tagen fielen die Impressions wieder auf den vorherigen Wert. Das Ranking hat im Testzeitraum etwas zugenommen, war jedoch nicht von Bedeutung.

Test 3: Bookmark auf einen Artikel in diesem Blog

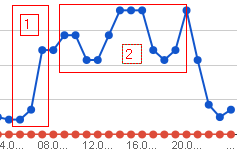

Auffallend ist, dass der Suchbegriff „gimp effekte“ bei der großen Suchmaschine 1.000 Impressionen auf einen Artikel in meinem Blog erzeugt. Die durchschnittliche Position ist mit „180“ allerdings sehr schlecht und führt dazu, dass natürlich auch keine Klicks über diese Keyword-Kombination erzeugt werden. Also wollte ich wissen, ob man mittels Bookmark diese Position verbessern kann. Für den Test habe ich also rund 70 Bookmarks auf den betroffenen Artikel mit dem Key „gimp effekte“ gesetzt. Werden die Suchmaschinen-Zugriffe „durch die Decke gehen“?

Weit gefehlt. Rund zehn Tage später zeigt das Bild keine signifikanten Verbesserungen. Der Graf bewegt sich im üblichen Rahmen, die „durchschnittliche Position“ ist jedoch von 180 auf 170 gesunken. Auf die Nachhaltigkeit zu dokumentieren habe ich verzichtet.

Fazit: Sind Bookmark sinnvoll?

Es hat bei meinem Test keine Verschlechterungen gegeben, wenn ich Bookmarks auf das Hauptprojekt gesetzt habe. Allerdings würde ich dem SEO-Rat folgen, keine Bookmarks auf ein Money-Projekt zu setzen. In meinen Tests haben die Bookmarks keine nachhaltige Verbesserung der Ergebnisse gezeigt. Sind Bookmarks also so schlecht wie ihr Ruf?

Bookmarks sind keine Geheimwaffe und das manuelle Setzen von Bookmarks sicherlich Zeitverschwendung (vielleicht von einer kleinen Handvoll bei gut platzierten Bookmark-Dienste mal abgesehen). Trotzdem kann die Anschaffung eines Bookmark Submitters sinnvoll sein. Das erstmalige Versorgen von Satelliten-Seiten wie Freeblogs oder ähnliche, welche ich im Rahmen des noch laufenden Test „Suchmaschinen optimieren in 10 Tage“ noch beschreiben werde, ist eine der Anwendungsmöglichkeiten. Dafür sind die rund 100 Euro Anschaffungspreis und die paar Dollar für dem De-Captcha-Dienst sicherlich gut angelegt. Doch bahnbrechende Erfolgsergebnisse darf man sich von Bookmarks nicht erhoffen.